| |

|

隔壁网希捷酷狼8T硬盘,正品国行,3年换新,只需要1320元,赠送论坛邀请码和VIP!

|

|

| |

|

隔壁网希捷酷狼8T硬盘,正品国行,3年换新,只需要1320元,赠送论坛邀请码和VIP!

|

|

| |

|

隔壁网希捷酷狼8T硬盘,正品国行,3年换新,只需要1320元,赠送论坛邀请码和VIP!

|

|

| |

|

|

| |

|

老李菜刀' Blog

TS409 Pro 低价转让ing...... |

|

| |

| |

| |

|

老李菜刀' Blog

TS409 Pro 低价转让ing...... |

|

|

|

| |

| |

| |

| |

|

|

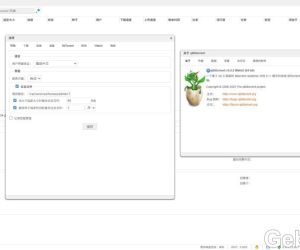

qBittorrent 套件分享1276 人气#黑群晖

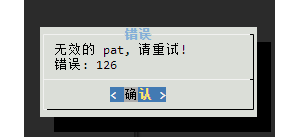

qBittorrent 套件分享1276 人气#黑群晖 无效的pat1523 人气#黑群晖

无效的pat1523 人气#黑群晖 使用lucky反代群晖后 手机端photos无法备份1342 人气#黑群晖

使用lucky反代群晖后 手机端photos无法备份1342 人气#黑群晖 DSM6 套件版qbittorrent 5.0.52962 人气#黑群晖

DSM6 套件版qbittorrent 5.0.52962 人气#黑群晖